목차

로지스틱 회기 Gradient 수식 풀이: 로지스틱

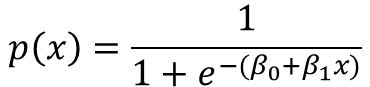

Logistic Regression은 위와 같이 시그모이드(Sigmoid) 함수 형태를 따릅니다.

수식은 다음과 같습니다.

입력 값이 많아지면 아래 수식2와 같이 표현 될 수 있습니다.

p(x)는 확률 값으로 0~1 사이로 표현 될 수 있습니다.

로지스틱 회기 Gradient 수식 풀이: Cost Function & Gradient

확률값의 Cost Function은 CE(Cross Entropy)로 표현 합니다. 엔트로피의 개념은 아래 링크를 참조하시길 바랍니다(https://scribblinganything.tistory.com/700). 크로스 엔트로피는 기존의 엔트로피에 자신의 예측치를 넣은 값으로 예측치와 실제 값이 맞을 확률이 높아 질수록 CE 값이 작아집니다.

아래는 이진 분류(Binary Classification) 수식입니다.

수식3에서 음수 기호를 붙힌 이유는 Cost Function으므로 최소 값이 가장 예측을 잘한 모델로 만들기 위해서 입니다.

Gradient를 구하기 위해 시그모이드 미분 함수가 필요한데 시그모이드 함수의 미분 특성은 아래와 같습니다.

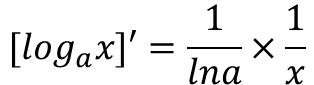

다음으로 log 함수의 미분 값을 알아야 합니다.

수식3을 수식5를 사용해서 전개하면 수식6과 같이 나옵니다.

수식4를 수식6에 적용하면 수식7이 나옵니다.

수식7은 최종적으로 수식8과 같이 나옵니다. 결국 앞서 선형회기의 Gradient(https://scribblinganything.tistory.com/703)와 거의 유사하게 나왔습니다.